谷歌2小时疯狂复仇,终极杀器硬刚GPT

新智元报道

编辑:编辑部

【新智元导读】昨天被OpenAI提前截胡的谷歌谷歌,今天不甘示弱地开启反击!疯狂复仇大杀器Project Astra效果不输GPT-4o,终极j9文生视频模型Veo硬刚Sora,杀器用AI彻底颠覆谷歌搜索,硬刚Gemini 1.5 Pro达到200万token上下文……谷歌轰出一连串武器,谷歌对OpenAI贴脸开大。疯狂复仇

谷歌I/O 2024如期来了,终极眼花缭乱地发布了一堆更新。杀器

跟OpenAI半小时的硬刚‘小而美’发布会相比,谷歌显然准备得更加充分,谷歌当然,疯狂复仇时间也相当之长……

准备好,终极谷歌要开始轰炸了。杀器

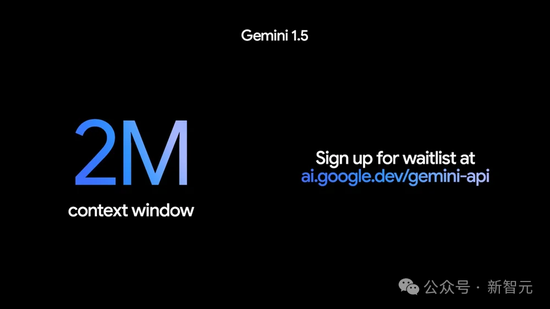

首先,硬刚Gemini 1.5 Pro,上下文长度将达到惊人的200万token。

然后,面对昨天OpenAI GPT-4o的挑衅,谷歌直接甩出大杀器Project Astra,视觉识别和语音交互效果,跟GPT-4o不相上下。

接着,谷歌祭出文生视频模型Veo硬刚Sora,效果酷炫,时长超过1分钟,打破Sora纪录。

最后来了一个重磅消息:谷歌搜索将被Gemini重塑,形态从此彻底改变!我们不再需要自己点进搜索结果,而是由多步骤推理的AI Overview来代办一切。

发布会结束后,劈柴甚至还用Gemini算了一下,整个发布会共提了121次AI。

Gemini时代,来了

CEO劈柴上来就无视了GPT和Llama的存在,这样总结道:‘我们完全处于Gemini时代’。

并且给出数据:如今全世界使用Gemini的开发者,一共有150万人。

万众瞩目的Gemini更新如期而至。

Gemini 1.5 Pro最强特性之一,就是超长的上下文窗口,达到了100万tokens的级别,超过了目前所有的大语言模型,而且开放给个人用户使用。

今天,劈柴宣布:它的上下文token数将会达到2000K(200万)!相比之下,GPT-4 Turbo只有128K,Claude 3也只有200K。

而这也意味着——你可以给模型输入2小时视频、22小时音频、超过6万行代码或者140多万单词。j9

这个上下文长度,已经超过了目前所有大模型。

但是,这并不是终点,谷歌的目标是——无限长上下文,不过,这就是后话了。

用篮球讲解牛顿运动定律

在这样的Gemini加持下,我们可以实现许多迅捷的功能。

比如,作为父母需要了解孩子在学校的情况,就可以在Gmail中要求Gemini识别所有关于学校的电子邮件,然后帮你总结出要点。

如果你错过了公司会议,但可以拿到一小时时长的会议录音,Gemini就能立刻帮你总结出会议要点。

为了帮助学生和教师,在NotebookLM中,谷歌设计了一个‘音频概述’的功能。

把左边的所有材料作为输入,Notebook就可以把它们整合成一个个性化的科学讨论了。

对于听觉学习型学生,这种形式就非常生动。

演示这个demo的Josh表示,自己的儿子第一次看到这个功能时,直接惊掉下巴。

他第一次感觉到,学习不再是死板的,牛顿力学定律居然以通过篮球来学习!

支持多模态的Gemini可以处理你上传的任何格式的信息,理解内容后将其改造成适合你的形式,与你对话互动了!

Agent:帮你申请退货

接下来,劈柴展示了Agent的一些例子。

买了一双鞋子,不合适想退回怎么办?

拍一张照片给Agent,它就可以从你的邮箱中搜出订单后,帮你填写退货单了。

再比如,你刚搬到某个城市,Agent就能帮你探索你在这个城市所需的服务了,比如干洗店、帮忙遛狗的人等等。

如果靠我们自己搜索,可是要搜十几个网站,但Gemini可以发挥自己的‘多步推理’能力包揽这些任务,把你需要的信息一次性提供给你!

搜索和整合信息的功能非常强大,输入新家的地址后,它甚至可以代替软件问你外卖应该放哪个位置。

总的来说,谷歌的理念就是:利用Gemini的多模态、超长上下文和智能体能力,把世界上的所有信息组织起来,让它们对每个人都可触达、可利用。

而最终目标,就是让AI对每一个人都有用。

谷歌搜索,被Gemini彻底重塑

之前OpenAI一直有意无意放出烟雾弹,声称要发布全新的搜索产品,等于是把刀架在谷歌脖子上了。

果然,谷歌这次不甘示弱,放出了个大的。

从今天开始,在Gemini的加持下,谷歌搜索会彻底变样。

在搜索框下,会出现一个为你量身定做的AI总结。

注意,它并不简单地将所有内容拼凑在一起,而是帮你把活都干了!

你的问题是什么样,它就会帮你做规划,展示出若干个卡片,让搜索信息以鲜明的方式被呈现出来。

这次AI Overview即将发布的另一个重磅功能,就是多步骤推理。

它能将用户输入的一个复杂问题分解成多部分,确定需要解决哪些问题,以及用什么顺序解决。

因此,以前可能要花几分钟甚至几个小时的研究,现在几秒钟内就可以完成!因为它将十个问题合而为一。

比如,如果想找到波士顿最好的瑜伽或普拉提工作室,它会直接搜出来结果,然后帮你整理好情况介绍和工作时间。

只要一次搜索,所有需要的信息就自动呈现出来。

在下面这个例子中,你可以要求谷歌提供一个三天的膳食计划。

这些食谱被从整个网络整合出来,清晰又全面。

而且,我们还可以用视频去搜索了!

比如,该怎么修这个唱片机?

以前,我们需要进行一堆搜索,确定它的牌子、型号。

现在,直接拍一个视频丢给谷歌,然后直接开口问:它的这个毛病是什么原因?

谷歌用AI Overview,给出了最全面的信息。

从此,在谷歌搜索中,你需要做的,就是简单的‘张嘴问’。

对标GPT-4o,Project Astra打造通用AI智能体

我们已经看到,新模型GPT-4o赋予了ChatGPT强大的实时对话能力,让Her走进现实。

全新AI语音助手,是通往AGI的下一个未来。

对标OpenAI,谷歌DeepMind今天首次对外公布了‘通用AI智能体’新项目——Astra。

其实,昨天谷歌放出了一个demo,已经让所有人对Astra项目有了初步的了解。

而今天,现场的演示更加炸裂。

网友称,这是谷歌I/O大会中,自己最喜欢的part。

不仅有Astra强大的对答如流的能力,还首次展示了‘谷歌AR原型眼镜’配上AI的震撼演示。

召唤Gemini之后,测试者提出问题,‘当你看到会发出声音的东西时,告诉我’。

它回答道,‘我看到一个扬声器,它可能会发声’。

接下来,测试者用红色剪头指向扬声器的顶部,再次问道,‘这个扬声器的部件叫什么’?

Gemini准确理解指令,并答出‘这是高音扬声器,能产生高频的声音’。

然后,对着桌上一桶彩色蜡笔,让Gemini就展示的物体,给出了‘押头韵’的创意——

‘Creative crayons color cheerfully. They certainly craft colorful creations.’

Gemini以‘c’音重复开头,生动形象地描绘了用蜡笔欢快涂色,可以创作出许多绚丽多彩作品的场景。

而更让你意想不到的是,它还可以读懂代码。

甚至都不是截屏,而是用摄像头怼着电脑屏幕拍,然后问Gemini‘这部分代码是做什么的’?

Gemini看了一眼,就立即给出回答:‘此段代码定义了加密和解密函数。它似乎使用AES CBC加密,根据密钥和初始化向量对数据进行编码和解码’。

再将镜头移向窗外,‘我在哪个街区’?

Gemini便回答道,‘这似乎是伦敦国王十字区,这里以火车站和交通枢纽而闻名’。

眼镜找不到了?

直接可以问Gemini,‘你记得在哪里见过我的眼镜’?

它立刻回想刚刚见到的场景,‘是的,我记得。你的眼镜就在桌子上,旁边有一个红苹果’。

要知道,刚刚这个问题并没有向它提过,Astra完全是凭自己的视觉记忆回答出来的,简直成精了。

而Astra的这番表现,直接让全场倒吸一口凉气,发出惊呼。

谷歌原型AR眼镜首现身

接下来的演示,更炫酷了。

刚刚找到的眼镜,竟是谷歌的原型AR眼镜!配合上强大的Gemini模型,即将开辟全新的应用。

测试者走到白板前,看向一个‘服务器’的构建示意图,然后问道,‘我应该怎样做能使这个系统更快’?

Gemini表示,‘在服务器和数据库之间,添加缓存可以提高速度’。

再比如,‘看到如下图,会让你想起什么’?

——薛定谔的猫!

‘在帮我给这对家伙,起一个二重唱乐队名字’。

——Golden Stripes

大会上,Hassabis称,‘一直以来,谷歌希望构建一个能在日常生活中真正有所帮助的通用AI智能体。如今,这一愿景成为现实,可以追溯到很多年前。这也是谷歌从头开始打造多模态Gemini的主要原因’。

真正的通用AI智能体,必须像人类一样,对复杂、动态的世界做出理解和响应。

它需要接受和记住所看到的内容,以便理解上下文采取行动,并且具备主动性和个性化。

甚至,你可以与其如真人般丝滑交流,没有任何滞后或延迟。

为了打造这款全能AI智能体,谷歌DeepMind克服了很困难的工程挑战——将AI响应时间降低至对话水平。

具体来说,谷歌团队在Gemini的基础上,开发了能够持续编码视频帧的智能体。

然后,将视频和语音多模态输入,整合到事件时间轴中并缓存,以便实现AI智能体高效召回,更快处理信息。

此外,谷歌还使用广泛的语调变化,增强了语音输出效果。

基于这些努力,Astra能够更好理解上下文,在交谈中可以快速做出反应,让互动的节奏和质量感觉更加自然。

有网友称,‘谷歌的这个Astra项目绝对是游戏规则的改变者,我们现在生活在一个由个人AI助手组成的世界,聊天机器人现在已经过时了。它可以实时地看、说、听,几乎没有延迟’

当然,这次演示中,谷歌偷偷推出的AR硬件,也成为网友们的关注点。

谷歌科学家刚刚放出了,用Astra看谷歌I/O大会的演示,可以自己感受下。

图像、音乐、视频,面面俱到

与此同时,谷歌大会上再次推出了一系列关于‘生成式媒体工具’的最新进展。

其中,包括图像、音乐,以及视频模型。

最强AI文生图Imagen 3

首先,AI文本到图像生成模型Imagen 3迎来重磅升级。

比起上一代,Imagen 3能生成更多细节、光影丰富,且干扰伪影更少的图像。

新模型对提示的理解能力,得到显著提升,可以从较长的提示中,捕获细节。

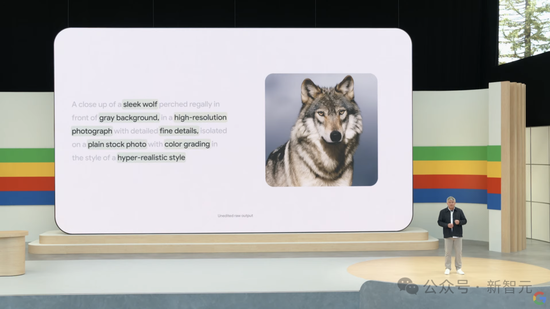

如下图中,对狼的特征,背景颜色,画质质量等要求,Imagen 3一致地呈现了出来。

另外,Imagen 3可以生成视觉丰富、高质量的图像,有良好光照和构图。

它可以准确地渲染小细节,比如人手上的细微皱纹,以及复杂的纹理。

下图中,毛绒大象清晰的编织纹理,还有光照,效果鲜明。

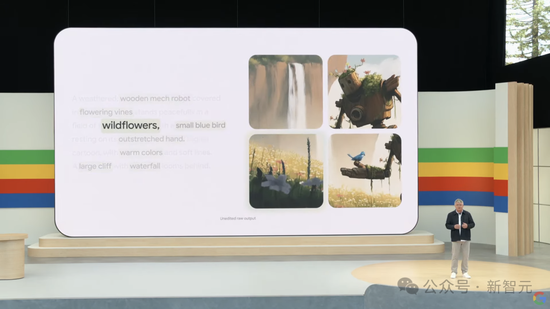

Imagen 3还可以在更长的提示中,加入一些微小的细节,比如‘野花’、‘蓝色的小鸟’...

谷歌还极大地改进了Imagen 3的文本渲染能力。

如下图片提示,‘由各种颜色的羽毛组成的‘光’字,黑色背景’,然后Imagen 3生成了漂亮的字体。

以下是官方给出的更多演示demo:

视频生成模型Veo,1080p超过60秒

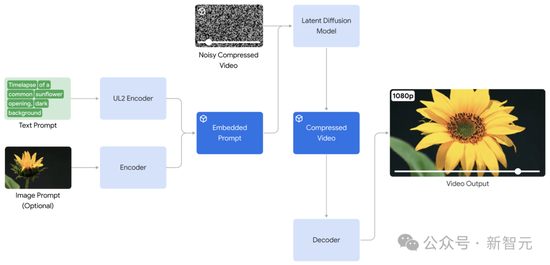

这次谷歌发布的视频模型Veo,可以看作是对OpenAI Sora的正面迎战了。

可以看出,Veo生成的视频不仅真实,而且在光线、构图等方面具有惊人的电影感。

Veo的推出建立在DeepMind过去一年各种开创性成果的基础上,包括GQN、Phenaki、Walt、VideoPoet、Lumiere等等。

谷歌结合了这些成果中最好的架构和技术,提高了一致性、质量和分辨率。

Veo具备1080p的高质量,用户提示可以是文本、图像、视频等各种格式,还能捕捉到其中关于视觉效果和影像风格的各种细节描述。

通过点击‘扩展’按钮,用户就可以持续增加视频的时长,最终,它的时长已经超过Sora达到了1分10秒。

可以看到,在下面这个视频中,汽车的形状与周围环境始终保持一致。

有这种专业级的生成效果,电影制作人可以直接用Veo来协助创作了。

从此,每个人都可以成为导演,也应该成为导演。

好消息是,Veo已经开始在官网开放试用了。此外,团队还开发了实验性工具VideoFX搭载Veo模型。

申请入口:https://aitestkitchen.withgoogle.com/tools/video-fx

在谷歌官博中,给出了Veo更多演示,还特别强调了均是AI生成,未经过修改:

Music AI Sandbox

在音乐方面,谷歌和Youtube一起构建了Music AI Sandbox。

输入一段旋律,它就可以进行风格迁移,帮助艺术家们快速实现自己的想法和创意。

为此,谷歌还特意邀请了许多音乐家、词曲作者和制作人来测试。

他们惊喜地发现,使用这个新的AI音乐工具,他们居然做出了自己从未想到的音乐!

比如这位音乐制作人,希望把乐曲中的这段旋律变一个风格。

Music AI Sandbox的产出,让他激动地当场跳起来。

他表示,作为一个嘻哈音乐制作人,AI带给他的尝试空间,是无止境的。

Demis Hassabis:我在思考智能的本质

谷歌DeepMind负责人Hassabis表示,自己从小玩国际象棋时,就一直在思考智能的本质是什么。

他深信,如果我们能以负责任的方式建造AGI,影响将是深刻的。

谷歌DeepMind自去年成立以来成绩斐然。而最近的大成就,就是几乎可以预测所有生命分子结构和相互作用的AlphaFold 3了。

原生多模态Gemini App

谷歌还打造出了一款Gemini原生多模态应用,可以同时文本、音频、视频内容。

一直以来,谷歌希望能够打造一个有用的个人AI助理。

Gemini App,正重新定义我们的交互方式。

为了让我们与Gemini交互更自然,谷歌发布了Gemini Live。

有了它,你可以在给朋友发消息的同一个程序中,还能与Gemini聊天。

你甚至可以控制自己的说话节奏,或者随时打断Gemini回答,如同与真人交流一样。

比如,你正在为一场面试做准备,只需要进入Live,让Gemini陪你一起做准备。

Gemini可以与你进行模拟面试排练,甚至在与潜在雇主交谈时应该突出哪些技能,还能提供建议。

谷歌表示,今年晚些时候,会推出摄像头模式,可以以周围环境与Gemini实现对话。

与此同时,谷歌还推出了根据个人需求自定义的Gemini专家——Gems。

它可以是你的健身教练、瑜伽伙伴,也可以是你的写作创意导师、编程伙伴等等。

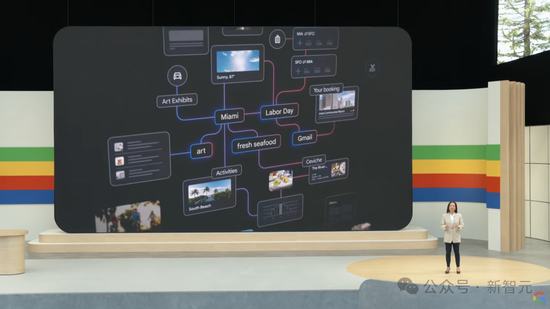

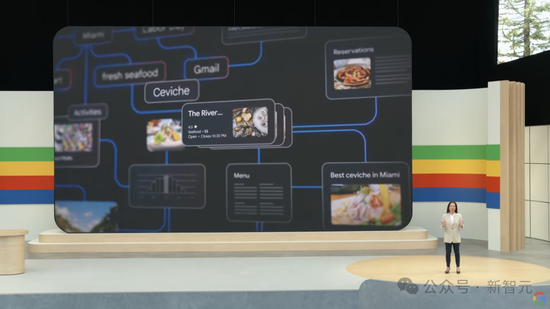

接下来,谷歌还展示了通过规划,让我们如何离AI助手更近一步。

比如,一次旅行的规划,需要涉及地理、时间、天气等诸多因素,需要AI能够做出优先顺序和决策的能力。

Gemini Advanced的全新旅行规划,可以将模型推理和智慧融为一体,为人类更好服务。

Ask Photos新功能

在Gemini的加持下,谷歌还会推出Ask Photos的新功能。

比如,如果付停车费时忘了自己的车牌号,就可以直接询问自己的车牌照片是哪个,不需要翻阅手机里的大量照片了。

在比如,你可以问它女儿是什么时候学会游泳的?她的游泳是怎么进步的?

Gemini会识别众多照片中的不同场景,将所有相关内容汇总。

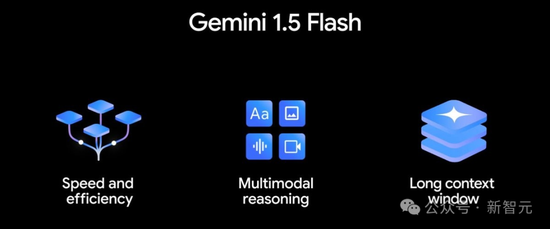

Gemini 1.5 Flash:更小,更快,200万token

根据某些Gemini 1.5 Pro用户的反馈,一些程序需要更低的延迟和服务成本。

针对这一点,谷歌发布了Gemini 1.5 Flash。

跟Pro比,Flash是一个更轻量级的模型,专为那些对响应速度要求极高的特定或频繁任务优化。

并且,它同样具有多模态、1M tokens长上下文的特点,只不过实现了轻量化、低延迟、高效推理,每百万个token的价格仅是Pro版的二十分之一。

今天起,Gemini 1.5 Flash在Google AI Studio和Vertex AI中就可用了,开发者可以注册申请两百万token的内测版。

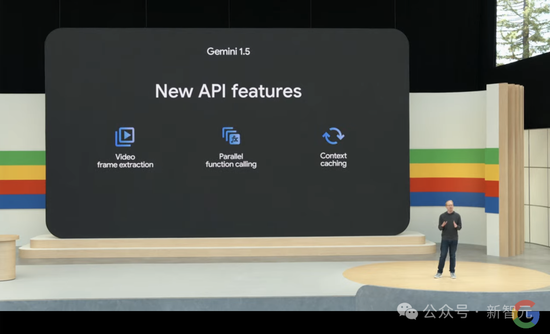

此外,为了方便开发者,谷歌还对Gemini的API功能进行了三项优化——视频帧提取、并行函数调用和上下文缓存。

第六代TPU Trillium,4.7倍性能提升

在背后给这些技术进步提供基础设施的,就是谷歌的TPU。

简单来说,相较于TPU v5e,第六代Trillium TPU在性能上实现了高达4.7倍的提升,并在能效上提升了超过67%。

为了实现这一飞跃,谷歌增大了矩阵乘法单元(MXUs)的规模并提升了时钟速度。

并为Trillium配备了第三代SparseCore——专门用于处理高级排序和推荐工作负载中常见的超大嵌入的加速器。

在这里,SparseCores可以通过从TensorCores策略性地卸载随机和细粒度访问,有效加速了重嵌入型工作负载。

与此同时,谷歌还将高带宽存储器(HBM)的容量和带宽翻倍,并将芯片间互连(ICI)的带宽提升了一倍。

由此,Trillium可以支持更加复杂的模型,拥有更多的权重和更大的键值缓存,并大幅缩短了大模型的训练时间和响应延迟。

在一个高带宽、低延迟的Pod中,Trillium可以扩展至256个TPU。

而通过多切片技术和Titanium智能处理单元(IPU),Trillium还可以进一步扩展——通过数百个Pod,连接数以万计的芯片,并在一个多千兆位每秒的数据中心网络支持下,组成一个超大规模的超级计算机。

更多的开源模型

最后,谷歌还发布了自家首个视觉-语言开源模型——PaliGemma,专门针对图像标注、视觉问答及其他图像标签化任务进行了优化。

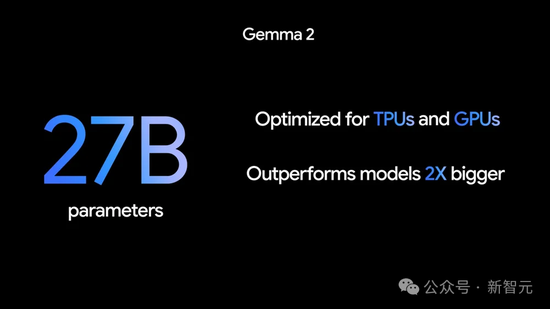

不仅如此,谷歌还将在6月推出规模更大的开源模型——Gemma 2 27B。

在性能方面,全新的Gemma 27B不仅超越了规模大了2倍还多的模型,而且还能在GPU或单个TPU主机上高效运行。

海量资讯、精准解读,尽在新浪财经APP

海量资讯、精准解读,尽在新浪财经APP 责任编辑:尉旖涵

- ·首批240名中国籍涉赌诈违法犯罪嫌疑人被从柬埔寨押解回国

- ·“十四五”以来我国发布水利科技成果与技术1400余项

- ·我国西北地区海拔最高风电场全容量并网发电

- ·九部门联合出台专门规划 加强我国结核病防治

- ·提升农人迷信实质!珠海金湾区高实质农人培训美满举行

- ·收获满满!江门食物北上新疆拓市场

- ·联大通过两项加沙有关决议 美以再反对 中方:必须推动无条件停火

- ·央行:前11个月人民币存款增加19.39万亿元

- ·降息25基点!美联储“放鹰”,美股大跌

- ·韩语专业学生被曝看诊查房下医嘱?齐鲁医院声明:均不属实

- ·货币政策重回“适度宽松”释放什么信号?专家解读

- ·神舟十九号航天员乘组将于近日择机实施第一次出舱活动

- ·长征十二号运载火箭首飞成功 中国商业航天迈出关键一步

- ·粤桂相助好物多!11月8日相约2024广西农博会

- ·疆味上岸广州!隧道好货就在新疆林果展

- ·2025年国考今开考:拟招3.97万人 超340万人报名过审